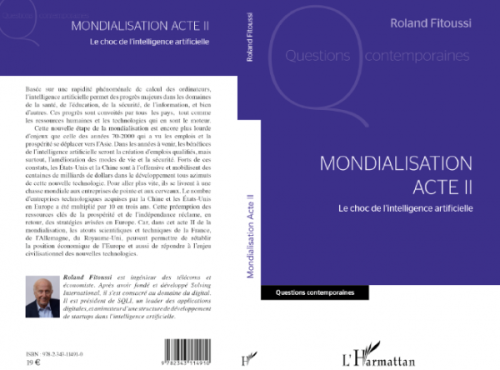

Revue TELECOM 187 - Quels verrous pour l'IA ?

QUELS VERROUS POUR L'IA ?

Par Jean-Louis Dessalles (1981) dans la revue TELECOM n° 187

Le progrès récent des techniques numériques d’apprentissage automatique est stupéfiant. Doit-on croire pour autant que des machines vont bientôt nous supplanter ? Peut-être pas.

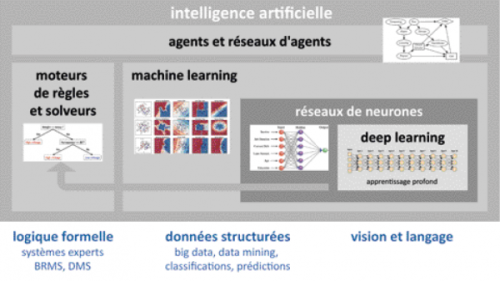

Le renouveau des techniques numériques en IA, au premier rang desquelles l’apprentissage profond (deep learning), exerce une fascination légitime non seulement sur le public, mais aussi sur de nombreux chercheurs. Quant aux étudiants de Telecom ParisTech, hier encore avides de vouer en masse leur vie aux big data, ils sont de plus en plus nombreux à s’inscrire dans des cours mentionnant les mots IA et machine learning, pourvu que l’adjectif deep soit mentionné quelque part dans le descriptif. On sait que des personnes en vue comme Stephen Hawking, Bill Gates ou Steve Wozniak ont publiquement exprimé leurs craintes que des machines nous supplantent un jour. Bizarrement, ces alertes semblent attiser la fascination récente pour les programmes intelligents plutôt que de la calmer. Leurs craintes sont-elles fondées ? Peut-on raisonnablement extrapoler à partir des techniques actuelles et prédire l’avènement de la singularité technologique, ce point de non-retour où l’intelligence des machines leur permettra de se passer de nous, du moins de supplanter l’humain ? Il est important de comprendre pourquoi la réponse est non. Il est important de connaître quelques-uns des obstacles, des verrous technologiques, qui nous séparent de l’avènement de machines qui pourraient, au moins en principe, rivaliser avec les humains.

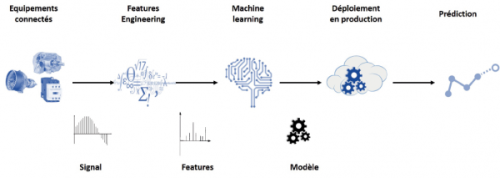

Les programmes intelligents récents sont d’extraordinaires machines à catégoriser. Décrire une scène visuelle, effectuer un diagnostic médical, prendre une décision d’achat, jouer au jeu de Go, tout cela peut se traiter .png) comme des opérations de catégorisation. Grâce à l’exploitation préalable d’une masse considérable de données, les programmes peuvent catégoriser telle image comme un bateau à quai, tel ensemble de symptômes comme une hépatite. L’apprentissage par renforcement permet d’évaluer ces catégories, ce qui est essentiel pour jouer en Bourse ou au Go. Il est tentant de croire que toute action intelligente peut être ainsi déduite de la compilation préalable d’une masse suffisante de données. Si cela est vrai, alors l’avènement de machines qui nous surpassent en tout est inévitable. Mais tous les verrous ont-ils vraiment déjà sauté ?

comme des opérations de catégorisation. Grâce à l’exploitation préalable d’une masse considérable de données, les programmes peuvent catégoriser telle image comme un bateau à quai, tel ensemble de symptômes comme une hépatite. L’apprentissage par renforcement permet d’évaluer ces catégories, ce qui est essentiel pour jouer en Bourse ou au Go. Il est tentant de croire que toute action intelligente peut être ainsi déduite de la compilation préalable d’une masse suffisante de données. Si cela est vrai, alors l’avènement de machines qui nous surpassent en tout est inévitable. Mais tous les verrous ont-ils vraiment déjà sauté ?

Je lisais récemment à ma petite fille l’histoire d’un personnage fantasque qui avait accroché son horloge à l’envers sur le mur. L’enfant de quatre ans éclata de rire. Elle comprenait qu’une horloge à balancier comme celle du salon ne pourrait pas fonctionner ainsi. L’enfant a utilisé sa capacité de simuler mentalement ce qui était décrit pour en tirer des conclusions. Nous sommes encore loin de doter les machines d’un pouvoir générique de simulation qui leur permettrait, par exemple, de décider finement des responsabilités à partir d’une description d’accident. Il s’agit là d’un premier verrou.

L’intelligence humaine se mesure parfois à l’aide de tests. Il est facile de continuer la suite 11223344. Si le test suivant est AABBCCDD, la personne testée sait qu’il s’agit du même test. Or un programme numérique d’apprentissage pourrait donner une réponse correcte dans le premier cas et incorrecte dans le second. Cette absence de systématicité est révélatrice de ce que le fonctionnement humain diffère qualitativement de celui des techniques numériques de machine learning. Supposons que le test suivant soit AABABC. Comment continuer cette suite de lettres ? La réponse vous semblera évidente après coup. Réfléchissez encore un peu. Si vous ne trouvez pas, prenez la première lettre avant de considérer les deux suivantes, et enfin les trois dernières. Evident, n’est-ce pas ? Un programme d’apprentissage numérique classique ne peut reconnaître la solution comme évidente, car il ne repère pas les mêmes structures que nous. Nous repérons les formes simples. C’est à cela que nous reconnaissons la solution comme bonne : elle simplifie l’exemple AABABC en le dotant d’une structure facile à décrire. Cette capacité à repérer des structures simples reste un problème difficile en IA. Elle constitue un deuxième verrou.

Imaginons une histoire à deux personnages, une chèvre et une chienne. Si l’on dit « Elle a aboyé au moment où la chienne était dans la niche », l’auditeur est obligé d’imaginer que c’est la chèvre qui a aboyé ! Ce n’est pas le cas avec la phrase « le fait qu’elle ait aboyé a révélé que la chienne était dans la niche ». Les linguistes savent produire une règle qui explique le phénomène. On sait inscrire de telles règles dans un programme symbolique, mais pas dans un programme d’apprentissage numérique. Il s’agit d’un troisième verrou.

Telecom ParisTech poursuit des recherches pour tenter de lever ces verrous (et quelques autres). Nous les cernons de mieux en mieux sur le plan théorique, même si nous ne savons pas quand ces progrès pourront passer à l’échelle. Il y a soixante ans, Alan Turing imaginait un programme capable de se faire passer pour un humain. Un tel programme doit savoir que l’écran que je regarde se trouvera sur ma gauche si je fais pivoter mon siège vers la droite ; il devra savoir comment compléter la suite 1x2xx3xxx4xxxx ; il devra comprendre pourquoi une phrase comme « Ça n’a l’air de rien, mais c’est pas grand-chose » est incongrue. Ces exercices si évidents pour nous sont hors de portée des techniques numériques actuelles et le resteront tant que les verrous que je viens d’évoquer ne seront pas levés. Ils le seront certainement un jour, mais ce jour est peut-être très lointain. La singularité et le remplacement des humains par des machines qui leur seraient supérieures ne sont probablement pas pour demain.

Biographie de l'auteur

Jean-Louis Dessalles (1981) est enseignant-chercheur en intelligence artificielle et sciences cognitives à Telecom ParisTech. Il développe notamment une théorie, la Théorie de la Simplicité (www.simplicitytheory.science), pour modéliser la notion de pertinence. Ces recherches peuvent être appliquées pour améliorer l’intelligence des machines dans l’interaction avec leurs utilisateurs humains. Il est l’auteur de plusieurs livres, parmi lesquels Why We Talk et Le fil de la vie.

dessalles@telecom-paristech.fr -