Retour au numéro

Vue 307 fois

21 juin 2023

L’intelligence artificielle de confiance : un défi technologique, sociologique et réglementaire

Publié par

Bertrand Braunschweig

|

N° 209 -

L’INTELLIGENCE ARTIFICIELLE - LES CRISES ET LES OUTILS DE LEUR MAÎTRISE

Si les personnes n’ont pas confiance envers les systèmes d’IA avec lesquels elles interagissent, elles les rejetteront. La confiance, en particulier envers les artefacts numériques dont l’IA fait partie, est une combinaison de facteurs technologiques et sociologiques. Il existe des programmes de R&D pour travailler sur ces facteurs, dont un des plus importants est l’initiative nationale Confiance.ai « Ingénierie de l’IA de confiance pour les systèmes critiques » portée par de grands groupes industriels. Dans cet article j’évoque également rapidement les perspectives en matière de réglementation et de normes.

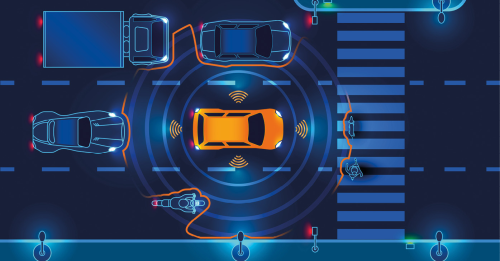

HeadingContexte : l’IA et le besoin de confiance Lorsqu’un modèle d’IA générative comme ChatGPT ou BARD produit des «hallucinations», qui sont des faits inventés de toutes pièces (par exemple attribuer à une personne un diplôme qu’elle n’a jamais obtenu), lorsqu’un chatbot conseille de mettre ses doigts dans la prise électrique à une petite fille qui lui demande un défi intéressant, lorsqu’un véhicule autonome manque de repérer un piéton et l’écrase, la confiance envers ces systèmes descend...

Cet article est réservé aux abonnés à la revue

Auteur

Bertrand Braunschweig